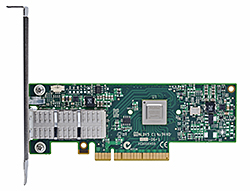

InfiniBand адаптеры Mellanox Connect-IB

Семейство адаптеров Connect-IB предоставляет пользователям очень высокую производительность в сочетании с максимальной пропускной способностью и малым временем задержки. Это дает возможность эффективно решать задачи, связанные с хранением данных и обработкой информации везде где критична высокая производительность. Максимальная пропускная способность при подключении к шине PCI Express 3.0x16 и два порта FDR InfiniBand обеспечивают пропускную способность более 100 Гбит/сек и малое время задержки при обращении ко всем ядрам CPU. Адаптеры Connect-IB позволяют извлечь все преимущества от использования FDR в тех вычислительных системах, где применяется шина PCI Express 2.0x16, за счет увеличения пропускной способности не менее чем в 2 раза по сравнению с существующими на сегодняшний день решениями.MCB191A-FCAT

MCB192A-FBAT

MCB194A-FCAT

MCB193A-FBAT

| FEATURES SUMMARY | |

| INFINIBAND | HARDWARE-BASED I/O VIRTUALIZATION |

| – IBTA Specification 1.2.1 compliant | – Single Root IOV** |

| – FDR 56Gb/s InfiniBand | – Up to 16 physical functions, 256 virtual functions |

| – Hardware-based congestion control | – Address translation and protection |

| – 16 million I/O channels | – Dedicated adapter resources |

| – 256 to 4Kbyte MTU, 1Gbyte messages | – Multiple queues per virtual machine |

| ENHANCED INFINIBAND | – Enhanced QoS for vNICs and vHCAs |

| – Hardware-based reliable transport | – VMware NetQueue support |

| – Extended Reliable Connected transport | PROTOCOL SUPPORT |

| – Dynamically Connected transport service | – OpenMPI, IBM PE, Intel MPI, OSU MPI (MVAPICH/2), Platforms MPI, UPC, Mellanox SHMEM |

| – Signature-protected control objects | – TCP/UDP, IPoIB, RDS |

| – Collective operations offloads | – SRP, iSER, NFS RDMA, SMB Direct |

| – GPU communication acceleration | – uDAPL |

| – Enhanced Atomic operations | |

| STORAGE SUPPORT | |

| – T10-compliant DIF/PI support | |

| – Hardware-based data signature handovers | |

| FLEXBOOT™ TECHNOLOGY | |

| – Remote boot over InfiniBand | |

| COMPATIBILITY | |

| PCI EXPRESS INTERFACE | OPERATING SYSTEMS/DISTRIBUTIONS |

| – PCI Express 2.0 or 3.0 compliant | – Novell SLES, Red Hat Enterprise Linux (RHEL), and other Linux distributions |

| – Auto-negotiates to x16, x8, x4, or x1 | – Microsoft Windows Server 2008/CCS 2003, HPC Server 2008 |

| – Support for MSI-X mechanisms | – VMware ESX 5.1 |

| CONNECTIVITY | – OpenFabrics Enterprise Distribution (OFED) |

| – Interoperable with InfiniBand switches | – OpenFabrics Windows Distribution (WinOF) |

| – Passive copper cable with ESD protection | |

| – Powered connectors for optical and active cable support | |

| Ordering Part Number | InfiniBand Ports | PCI Express |

| MCB191A-FCAT | MCB194A-FCAT | 3.0 x8 |

| MCB192A-FCAT | Dual FDR 56Gb/s | 3.0 x8 |

| MCB193A-FCAT | Single FDR 56Gb/s | 3.0 x16 |

| MCB194A-FCAT | Dual FDR 56Gb/s | 3.0 x16 |

MCB191A-FCAT |  MCB192A-FCAT |

MCB193A-FCAT |  MCB194A-FCAT |