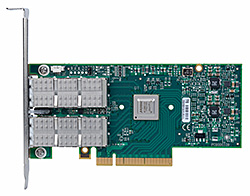

Ethernet адаптеры Mellanox Connect X3

Датацентры, в которых используются виртуальные серверы, предъявляют высокие требования к инфраструктуре ввода-вывода. Обладая пропускной способностью 10/40/56 Гбит/сек адаптеры компании Mellanox удовлетворяют требованиям к полосе пропускания в виртуальной среде. А с учетом совместимости с предыдущими версиями протокола передачи данных, сетевые карты 40/56GbE могут быть использованы в сетях 10GbE, давая возможность IT-персоналу постепенно перейти на новый стандарт 40/56GbE.Сервисам web 2.0 необходима широкая полоса пропускания, помимо этого необходимо разгрузить центральные процессоры от обработки сетевых пакетов для того, чтобы обеспечить высокую производительность дата центров. Ethernet-адаптеры компании Mellanox обеспечивают пропускную способность 10/40/56GbE, обрабатывают сетевые пакеты без участия центральных процессоров и обеспечивают прямой доступ к памяти в сетях Ethernet (RoCE), тем самым позволяя датацентрам эффективно работать, обеспечивая при этом высокий уровень масштабируемости.

Финансовым институтам, которые пользуются приложениями для совершения огромного количества операций купли-продажи или операций обмена данными, нужны коммутационные среды с низким временем задержки. Ethernet-адаптеры компании Mellanox предоставляют пользователям прямой доступ к памяти (RDMA) с малым временем задержки для достижения предельной оптимизации производительности сети.

Производительность Ethernet мирового класса

Ethernet-адаптеры компании Mellanox с применением технологии IBTA RoCE позволяют эффективно реализовать RDMA, обеспечивая работу приложений, которые чувствительны к полосе пропускания и времени задержки. Благодаря совместимости Ethernet-инфраструктуры на физическом уровне сетевые администраторы могут эффективно использовать существующие решения для построения коммутационной сети своих датацентров.

Приложениям, использующим передачу данных по TCP/UDP/IP, может потребоваться пропускная способность 10/40/56GbE. Такие возможности, как аппаратная разгрузка центрального процессора реализованные в адаптерах адаптеров Mellanox, позволяют снизить нагрузку, связанную с передачей IP-пакетов, на центральные процессоры и освободить вычислительные мощности их для работы с приложениями. Программное обеспечение для ускорения запущенных процессов повышает производительность работы приложений, чувствительных ко времени задержки.

Виртуализация I/O

Адаптеры от компании Mellanox предоставляют весь необходимый функционал предъявляемый к сетевым адаптерам для виртуализации, гарантируют изоляцию и защиту для виртуальных машин (VM) размещенных на сервере. Адаптеры от компании Mellanox предоставляют возможность персоналу, управляющему дата центрами, более эффективно использовать сервера, применять унификацию LAN и SAN, снижать стоимость и энергозатраты, существенно упростить кабельную инфраструктуру.

Сети Overlay

Для современных больших "облаков" нужны протоколы, реализующие передачу данных в Overlay сетях, для обеспечения защищенности и изоляции виртуальных машин внутри облака и для преодоления ограничений, накладываемых VLAN. Адаптеры с реализованной в них функцией аппаратной разгрузки центрального процессора для VXLAN и NVGRE дают поставщикам облачных сервисов уникальный шанс снизить нагрузку на центральный процессор, а следовательно снизить операционные расходы и капитальные затраты. Такой подход позволяет обслуживать большее количество пользователей для одного и того же облачного сервиса.

MCX311A-XCAT

MCX341A-XCAN

MCX341A-XCBN

MCX312A-XCBT

MCX342A-XCAN

MCX313A-BCBT

MCX314A-BCBT

| FEATURE SUMMARY* | |

| ETHERNET | HARDWARE-BASED I/O VIRTUALIZATION |

| – IEEE 802.3ae 10 Gigabit Ethernet | – Single Root IOV |

| – IEEE 802.3ba 40 Gigabit Ethernet | – Address translation and protection |

| – IEEE 802.3ad Link Aggregation and Failover | – Dedicated adapter resources |

| – IEEE 802.3az Energy Efficient Ethernet | – Multiple queues per virtual machine |

| – IEEE 802.1Q, .1p VLAN tags and priority | – Enhanced QoS for vNICs |

| – IEEE 802.1Qau Congestion Notification | – VMware NetQueue support |

| – IEEE P802.1Qbb D1.0 Priority-based Flow Control | ADDITIONAL CPU OFFLOADS |

| – IEEE 1588 Precision Clock Synchronization | – RDMA over Converged Ethernet |

| – Jumbo frame support (1024B) | – TCP/UDP/IP stateless offload |

| – 128 MAC/VLAN addresses per port | – Intelligent interrupt coalescence |

| FLEXBOOT™ TECHNOLOGY | |

| – Remote boot over Ethernet | |

| – Remote boot over iSCSI | |

| COMPATIBILITY | |

| PCI EXPRESS INTERFACE | MANAGEMENT AND TOOLS |

| – PCIe Base 3.0 compliant, 1.1 and 2.0 compatible | – MIB, MIB-II, MIB-II Extensions, RMON, RMON 2 |

| – 2.5, 5.0, or 8.0GT/s link rate x8 | – Configuration and diagnostic tools |

| – Auto-negotiates to x8, x4, x2, or x1 | OPERATING SYSTEMS/DISTRIBUTIONS |

| – Support for MSI/MSI-X mechanisms | – Citrix XenServer 6.1 |

| CONNECTIVITY | – Novell SLES, Red Hat Enterprise Linux (RHEL), Fedora, and other Linux distributions |

| – Interoperable with 10/40GbE Ethernet switches. Interoperable with 56GbE Mellanox Switches. | – Windows Server 2008/2012 |

| – Passive copper cable with ESD protection | – OpenFabrics Enterprise Distribution (OFED) |

| – Powered connectors for optical and active cable support | – OpenFabrics Windows Distribution (WinOF) |

| – QSFP to SFP+ connectivity through QSA module | – Ubuntu 12.04 |

| – VMware ESXi 4.x and 5.x | |

| Ordering Part Number | Ethernet Ports | Dimensions w/o Brackets |

| MCX311A-XCAT | Single 10GbE SFP+ | 10.2cm x 5.4cm |

| MCX312A-XCBT | Dual 10GbE SFP+ | 14.2cm x 6.9cm |

| MCX313A-BCBT | Single 40/56GbE QSFP | 14.2cm x 5.2cm |

| MCX314A-BCBT | Dual 40/56GbE QSFP | 14.2cm x 6.9cm |

MCX311A-XCAT, MCX341A-XCAN, MCX341A-XCBN |  MCX312A-XCBT, MCX342A-XCAN |

MCX313A-BCBT |  MCX314A-BCBT |